引言

研究背景及意义

近年来,无人机(UAV)技术迅速发展,凭借其机动灵活和高空视野优势,被广泛应用于应急救援、设施巡检、安防监控等任务场景。在这些复杂环境中,无人机需要对周围环境进行全面感知与理解,以保障任务的安全高效执行。这要求无人机具备实时的视觉感知能力,包括对全局场景的语义分割以及对关键目标的检测与追踪。全局语义分割提供逐像素的语义信息,使无人机能够分辨不同类别的地物(如道路、建筑、人员等),为路径规划和决策提供依据;目标检测与追踪则使无人机可以发现并持续锁定感兴趣的目标(如遇险人员、可疑物体),实现精细化的监视与搜救。这要求无人机具备实时的视觉感知能力,包括对全局场景的语义分割以及对关键目标的检测与追踪。全局语义分割提供逐像素的语义信息,使无人机能够分辨不同类别的地物(如道路、建筑、人员等),为路径规划和决策提供依据;目标检测与追踪则使无人机可以发现并持续锁定感兴趣的目标(如遇险人员、可疑物体),实现精细化的监视与搜救。其中,语义分割作为关键手段,被广泛用于无人机视角下场景的理解和关键目标的识别,满足多种典型应用需求。

首先,小目标感知是无人机低空监测的重要任务,例如识别地面上的行人、车辆、航空障碍物等小尺度目标。这些目标通常占据的像素区域极小,常规算法易漏检,因此需要高分辨率特征提取和分割算法来提高对小目标的敏感性。其次,动态障碍检测对于无人机自主避障和航路规划至关重要。无人机飞行环境中可能出现运动物体(如飞鸟、其他无人机、行驶车辆等),语义分割可以用于实时分割出这些动态物体的区域,为后续的轨迹预测和规避提供像素级信息支持。再次,背景干扰分离是指从复杂背景中分离出感兴趣的前景目标,以减少背景杂波对决策的干扰。无人机低空视角下场景复杂多变,如城市环境中建筑、道路与阴影交织,森林环境中树冠与地表混杂,这些都会形成大量背景纹理干扰。通过语义分割,将背景类别(如天空、地面、建筑物等)与前景目标(如障碍物、着陆区)分开,有助于提高感知的鲁棒性。例如,在应急迫降场景中,可通过语义分割识别出屋顶等平坦安全的着陆区和天线等障碍物,将车辆、树木等无关物体归入背景,从而辅助无人机做出安全降落决策。又如在精准农业中,无人机利用语义分割区分作物与杂草、土地,实现精细化农田管理。同样地,在巡检巡逻任务中,语义分割可提取道路、行人、车流等关键信息,提升无人机对环境态势的理解。总之,语义分割赋予无人机“看懂”低空场景的能力,使其能够满足小目标监测、动态障碍识别、前景背景分离等多方面需求,成为无人机自主飞行与环境感知中的核心技术之一。

尽管语义分割在无人机视觉应用中展现出巨大潜力,但受限于无人机平台和低空场景自身的特点,当前方法仍面临诸多挑战和局限,需要进一步的研究加以解决。首先,视角和尺度变化带来的不利影响。无人机可在空中以俯视或倾斜视角观察地面,物体的外观与常规地面视角有很大差异;同时无人机影像具有显著的尺度变化,同一帧画面中既包含近距离的大目标,也包含远处的微小目标。这种尺度不均衡和视角变化要求分割模型具有很强的多尺度鲁棒性,但现有模型往往难以兼顾,高空视角下对远小目标的分割精度常不理想。其次,复杂背景与光照条件。低空环境下背景往往复杂多变,例如城市中的杂乱街景、自然环境中的树丛和阴影等。背景的多样性和纹理细节会对分割算法造成干扰,容易产生误分类。此外,无人机户外飞行会遇到剧烈变化的光照和天气条件(如强烈阳光、夜间弱光、阴影、雾霾等),现有模型在训练数据中难以涵盖所有情况,导致在非理想光照下分割性能急剧下降。第三,小目标和边界细节带来的挑战。无人机影像中大量重要目标(如电线杆、行人等)只占很少像素,属于典型的小目标,容易在下采样的网络中特征淹没 ;同时,精确识别物体的边缘轮廓对于避障和测量至关重要,但复杂场景下保持边界细节清晰非常困难。尽管一些轻量级模型和多尺度融合技术有所改进,这些细粒度信息的捕获仍是瓶颈之一 。第四,实时性和算力限制。无人机往往搭载嵌入式处理器,对算法的推理速度和资源消耗有限制。许多高精度语义分割模型参数量大、计算开销高,难以在无人机端实时运行,造成实际部署困难。为此需要在模型轻量化与精度之间寻找平衡。最后,通用性与可扩展性的局限。传统语义分割模型通常是针对特定数据集和预定义类别训练的,缺乏对新环境、新目标的泛化能力。例如,一个模型若未见过某类新的障碍物,则可能无法正确分割识别。这对于开放环境下无人机任务是不利的。标注新的数据并重新训练模型代价高昂,限制了语义分割在动态多变场景下的应用。

本毕业设计以四旋翼无人机为载体,针对复杂环境提出了一套融合语义分割与自主飞行的闭环系统。通过“感知-决策-控制”分层架构,结合轻量化SAM模型的多模态数据融合机制,实现了无人机在动态障碍环境中的语义理解与实时避障导航。系统通过模块化设计与嵌入式优化部署,验证了其在结构化通道飞行与动态避障场景下的鲁棒性和实用性,为小型无人机在受限资源下的智能自主飞行提供了可行方案。

语义分割的经典方法与主流模型

语义分割技术在深度学习的推动下取得了长足发展。早期的里程碑是 Long 等人提出的全卷积网络(Fully Convolutional Network, FCN)[1]。FCN 首次采用仅由卷积层构成的端到端架构来替代传统分类网络的全连接层,实现了对输入图像逐像素的语义标签预测。在此基础上,学者们提出了多种改进模型以提高分割精度。例如,Ronneberger 等人提出的 U-Net 网络采用对称的编码器-解码器结构并通过跳跃连接融合高低层特征,在医学影像分割中取得出色效果[2]。随后,Chen 等人开发了 DeepLab 系列模型,在引入空洞卷积(又称扩张卷积)以扩大感受野的同时结合全连接条件随机场(CRF)后处理来细化分割边界[3][4]。空洞卷积的应用使网络在不增加参数的情况下有效聚合多尺度信息[5],而条件随机场的融合则显著改善了物体边缘处的标签一致性[6]。此外,赵等等人提出的金字塔场景解析网络(PSPNet)通过金字塔池化模块捕获不同尺度的上下文信息,实现对图像全局语义的建模[7]。Lin 等人提出的 RefineNet 则采用多路径特征融合与逐级精细化策略,在保持高分辨率预测的同时提升了分割准确率[8]。以上这些经典模型及技巧(如空洞卷积、多尺度金字塔池化、CRF 后处理和编码器-解码器架构等)构成了语义分割领域的主流方法体系,在 PASCAL VOC、Cityscapes 等数据集上不断刷新精度纪录。需要指出的是,这些精度提升往往以更高的模型复杂度和推理开销为代价;因此在追求精度的同时,如何权衡效率也成为一大关注点。

视频语义分割的研究进展

将语义分割从静态图像拓展到视频序列,会面临帧间一致性和计算效率方面的新挑战。传统做法是逐帧独立分割,但这种方法既未利用视频的冗余信息,又容易出现帧间抖动不一致。近年来,研究者提出了多种视频语义分割策略以提高连续帧分割的连贯性和效率。其中一类方法借助光流估计在帧间传播分割结果或特征。例如,Zhu 等人提出的深度特征流方法(Deep Feature Flow, DFF)利用光流网络将关键帧的高层特征映射到邻近帧,从而无需对每帧都执行完整卷积推理,实现了约3倍于逐帧方法的分割速度提升,而精度仅下降约1%[9]。类似地,Shelhamer 等人的 Clockwork 卷积网络通过在不同层采用不同的特征刷新周期,重用历史帧的中间特征来减少计算开销[10]。另一类方法侧重于利用时间信息提高分割精度和帧间一致性。例如,Nilsson 和 Sminchisescu 提出利用门控循环单元和光流估计相结合的时空传播模型,在逐帧分割基础上增加一个根据光流不确定性自适应地传播上一帧分割结果的模块,显著提升了视频分割结果的时间连续性和整体准确率[11]。同时,一些记忆网络和时序注意力模型也被引入视频分割,以在长程序列中关联目标。例如,Gadde 等人通过学习到的特征变形(warping)将前帧的卷积特征映射到当前帧,实现跨帧的信息更新,从而提高了视频分割的稳定性[12]。Xu 等人提出的 DVSNet 模型进一步引入自适应关键帧调度策略:通过一个决策网络动态判断场景变化幅度并决定是否更新分割关键帧,从而在保证精度的前提下最大化利用帧间冗余以提升效率[13]。最近,基于视觉Transformer的方案也开始应用于视频语义分割,通过自注意力机制建模时空依赖关系,取得了比传统卷积RNN方法更优的时序一致性。总的来看,视频语义分割研究进展主要沿两条路线拓展:一是利用光流和关键帧技术减少冗余计算,实现实时或近实时分割;二是融合时序信息和记忆机制,提高跨帧预测的一致性和鲁棒性。这两方面的成果使得在诸如 Cityscapes 等视频序列数据集上,分割结果的稳定性和速度均有明显提升。

SAM 模型的提出背景与静态图像分割表现

大规模基础模型的发展也为语义分割带来了新的范式突破。2023年,Meta AI 提出了 Segment Anything Model(SAM)[14],这是一个面向分割任务的基础模型。SAM 的提出背景在于构建一个“万物可分”的通用分割模型,以prompt(提示)为驱动,实现对任意新目标的零样本分割[14]。SAM 的核心能力在于其出色的泛化性能和交互式分割能力:未经针对特定任务的微调,它在此前未见过的物体和图像上亦能产生高质量的分割结果,实现了真正的零样本分割。这一点在静态图像分割中表现突出——例如在自然场景、网页图片乃至医学影像上,SAM 都展示了强大的通用分割能力,大幅减少了人为标注的工作量。针对视频场景下的分割需求,Meta 随后推出了 Segment Anything Model 2 (SAM2) [15],将可提示分割的理念拓展至时序序列。最近的的一些研究对 SAM 进行了扩展,例如通过引入高质量输出标记来训练细粒度掩码[16],或提升 SAM 的效率[17]。更广泛地,SAM 被应用于多种领域,包括医学成像[18-20]、遥感[21-22]、运动分割[23]以及伪装目标检测[24]。

无人机平台语义分割的适配挑战

将语义分割应用于无人机(UAV)平台的空中影像中,还面临诸多独特挑战[25]。首先是尺度变化问题:无人机可在不同高度飞行,导致摄像画面中物体呈现的尺寸变化巨大。例如,同一辆汽车在低空近距离时占据图像的大部分区域,而在高空远距离时可能只有几个像素大小。这种跨尺度的目标对现有模型的多尺度感知能力提出了更高要求。其次是动态视角带来的挑战:无人机搭载的摄像头视角灵活多变,既可能俯视场景又可能斜视侧视,且在飞行中持续变化。传统地面摄像头常见的视角局限(如行车记录仪主要是前向水平视角)在无人机场景中被打破,每一帧图像的透视投影可能不同。这种倾斜视角(oblique viewpoint)会导致物体外观和形状发生复杂变化,增加了语义分割的难度。第三,光照条件变化剧烈:无人机户外作业会遇到不同的天气和昼夜条件,影像中可能出现强光、阴影甚至夜晚弱光等极端情况。光照变化会显著影响图像的像素分布,使模型难以泛化。在夜间场景下,常规分割模型精度往往大幅下降,如何提高低光照下的分割性能仍是开放问题。第四,算力与实时性限制:无人机受载重和能源限制,其搭载的计算平台性能有限,很难运行庞大的深度模型。此外,无人机应用(如自主飞行、目标跟踪)通常要求实时或接近实时的分割反馈,这更加剧了对算法效率的要求。需要轻量级但精度有保障的模型以适应无人机机载部署[26]。最后,无人机场景中常出现运动目标和快速变化的背景,这对视频分割的时序稳定性提出了挑战;模型不仅要识别出每帧的新目标,还需保持跨帧的一致性,避免出现抖动和重影。这些因素共同造成了无人机语义分割的适配难题,需要在数据采集和算法设计上作特别考虑。因此,在无人机平台部署语义分割,需要综合考虑上述因素,对模型的多尺度特征提取、视角归variant处理、光照鲁棒性以及模型轻量化等方面提出更高要求。

针对 UAV 场景的语义分割适配研究

为应对无人机影像的特殊挑战,近年出现了许多针对 UAV 场景优化的语义分割研究。首先是在数据集和基准方面,研究者构建了专门的无人机分割数据集以推动算法发展。典型如 Lyu 等人发布的 UAVid 数据集[25],该数据集包含高分辨率的航拍视频序列,手工标注了8类城市目标。由于拍摄角度为倾斜视角,UAVid 带来了不同于传统地面数据集的新挑战,包括前述的大尺度变化和时序一致性问题。又如 UAVDT 数据集[26]和 VisDrone 数据集[27],虽然主要用于目标检测和跟踪任务,但其丰富的城市道路、广场、高速公路等航拍场景也为语义分割提供了宝贵参考。例如,Ji 等人提出的 PPTFormer 模型[28]针对无人机的动态视角问题,巧妙地引入了伪多视角学习:在训练过程中生成模拟的多视角影像来增强模型对视角变化的适应性。另外,一些研究将基础模型引入无人机分割任务,以减少对大规模标注数据的依赖。Cao 等人提出了一种基于 SAM 的弱监督语义分割方法[29],通过少量点标注对 SAM 模型进行不确定性约束和变换一致性训练,使其更好地适应无人机遥感影像的分割需求。这些探索共同推动了针对无人机场景的语义分割技术的发展。在综述国内外相关研究现状后可以看到,通过构建专门的数据集和提出有针对性的模型改进,语义分割技术正逐步克服无人机平台下的各种适配挑战,为空中视觉感知,如无人机巡检、灾害监测和城市管理等应用,提供越来越可靠的技术支撑。

论文组成部分

本文会分为四个章节,第一章节简述语义分割的研究现状及其在无人机上的应用研究;第二章节主要介绍语义分割的基础知识和硬件框架,为研究的内容提供基础;第三章节主要介绍我们使用的Meta AI提出的SAM2的算法,阐述其技术的基本原理和算法的创新;第四章介绍我们本次实验的任务框架,并进行仿真和实机测试,完整对整个系统的可行性验证。

相关框架

SAM技术框架

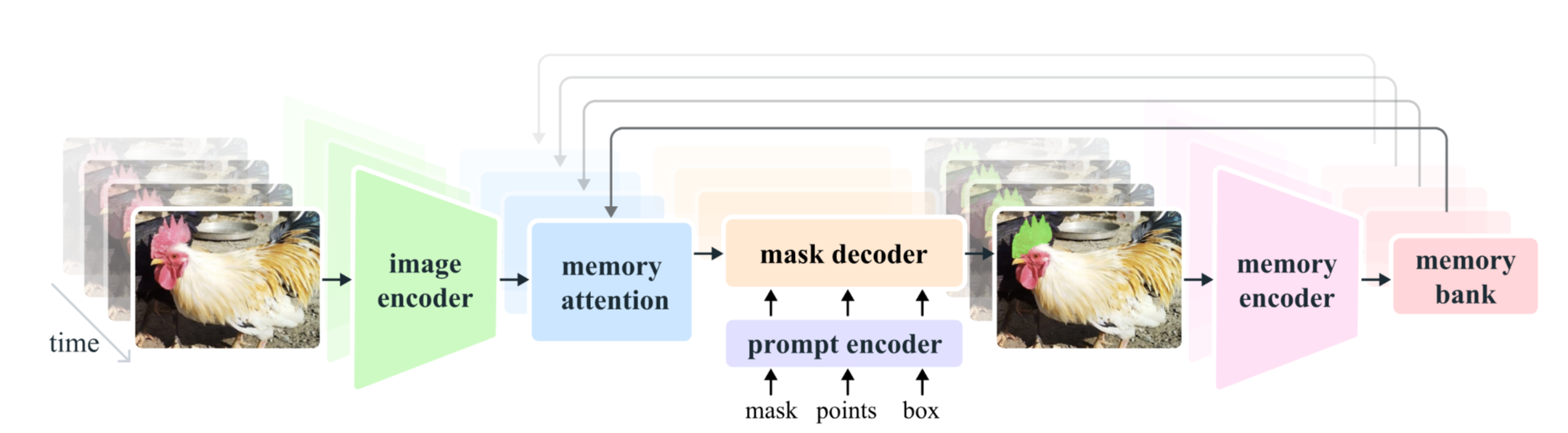

模型架构概览

Segment Anything Model 2 (SAM 2) 采用了简单而高效的模块化架构,以满足灵活提示、实时交互和消歧(ambiguity-aware)的需求。它由四个主要组件构成:一个强大的图像编码器,一个灵活的提示编码器,一个轻量级的掩码解码器以及一个**流式记忆机制和跨注意力模块。图像编码器负责对输入图像提取通用特征表示;提示编码器将用户提供的提示信息(点、框、文本或掩码)映射为嵌入向量;掩码解码器则融合图像特征和提示嵌入来预测目标区域的分割掩码;记忆模块实现了对任意长度视频的实时处理与时序一致性建模。通过将重计算的图像特征提取与快速的提示编码/解码分离,SAM 实现了对同一张图像多次提示的高效处理——图像编码只需运行一次,不同提示下重复利用同一图像嵌入即可快速生成结果。此外,SAM 被设计为模糊感知的:对于存在歧义的提示,模型不会强制输出单一结果,而是能够针对一个提示生成多个合理的掩码候选并给出置信评分,从而自然地处理诸如“衣服上的点可能指向衣服或人体”等歧义情况。

图像编码器(Image Encoder)

图像编码器是 SAM 的特征提取 backbone。其作用是将输入图像转换为高维的图像特征嵌入表示。SAM 使用了经过 MAE [30]方法预训练的 Vision Transformer(ViT)[31] 模型作为图像编码器。选择 ViT 的原因在于其强大的表征能力和可扩展性:ViT 可以在大规模数据上训练并有效提取通用视觉特征。为了适应高分辨率输入,SAM 对 ViT 结构进行了最小程度的改动 [32],使其能够处理如 1024×1024 像素的图像并保持计算可行。具体实现上,SAM 的图像编码器采用了 ViT-H/16 结构(即 patch size 为16的ViT-Huge模型)。输入图像首先被划分为16×16的patch并映射到高维空间,经过Transformer编码后输出一个降低了分辨率的特征图。例如,对于1024×1024的输入图像,编码器输出大小约为64×64的空间特征图,每个特征向量维度经降维约为256(通过1×1卷积等降低通道维数)。这相当于将原图下采样16倍,同时保留丰富的语义信息。图像编码器的输出即图像嵌入(image embedding),表示为一个较低分辨率的特征图$F(I)$,后续将作为解码的基础。图像编码器在每张图像上仅需运行一次:对于同一图像,无论后续给出多少不同提示,其昂贵的特征计算都可复用。这一设计大幅提升了多次交互分割的效率,使得 SAM 能够在交互式应用中实时响应。

提示编码器(Prompt Encoder)

提示编码器负责将用户提供的提示信息转换为模型可理解的嵌入表示。SAM 支持多种形式的提示,包括稀疏提示和稠密提示两大类:

- 点和框(Sparse Prompts):点(例如前景点或背景点)和边界框是常用的空间提示。对于点提示,SAM将点的图像坐标通过位置编码(positional encoding)[33]映射到嵌入空间,并加上一个指示类型的嵌入向量(例如区分前景点/背景点)。边界框则可由其对角点表示,分别进行位置编码后再结合表示框的特殊嵌入类型。通过这种方式,点和框被表示为与图像特征同维度(例如256维)的向量嵌入。

- 文本提示(Sparse Prompt):SAM 还探索了自由格式文本作为提示的可能性。文本提示通过预先训练好的文本编码器(如 CLIP 的文本编码器)[34]提取嵌入表示。尽管文本提示在当前实现中属于初步结果,但在架构上,文本嵌入可以与其他提示方式类似地输入掩码解码器,从而实现基于语义的分割。

- 掩码提示(Dense Prompt):除了稀疏提示,SAM 还能接受掩码作为提示。掩码本身是一种与图像同尺寸的二值图(例如用户提供的粗分割或示例掩码)。SAM 通过一个小型卷积网络将输入掩码编码为与图像嵌入相同空间尺寸的特征图,然后将其与图像编码器的特征图按元素加和融合。这种融合使模型在解码阶段能够参考已有掩码信息,从而细化或校正最终的分割结果。

经过提示编码器处理后,不同类型的提示均被转化为统一形式的提示嵌入(prompt embedding),并对齐到掩码解码器所需的维度(例如256维)。这些提示嵌入将与图像嵌入一起送入掩码解码器,指导模型生成相应的分割掩码。

掩码解码器(Mask Decoder)

掩码解码器是 SAM 中将图像特征和提示信息结合、产出分割结果的核心模块。它采用了一种改进的 Transformer 解码器结构[35],对嵌入进行多轮交互更新并输出掩码。掩码解码器的输入包括:图像编码器输出的图像嵌入、提示编码器输出的提示嵌入,以及若干个用于预测掩码的输出令牌(output tokens)。其内部机制可以概括如下:

多模态注意力融合:掩码解码器首先对提示嵌入序列(包括提示向量和输出令牌)执行自注意力(self-attention),使各提示信号和输出令牌之间相互通信。随后,解码器执行双向的交叉注意力(cross-attention):一方面,让提示序列作为查询,从图像嵌入(键和值)中检索相关的视觉特征(prompt-to-image cross-attention);另一方面,也让图像嵌入作为查询,从提示序列中获取与位置相关的提示信息(image-to-prompt cross-attention)。这种双向交叉注意力的机制确保了图像特征和提示在解码过程中充分融合:提示引导模型关注图像中特定区域或语义,图像特征反过来也可以调整提示嵌入的表征。SAM 的掩码解码器堆叠了两层上述的 Transformer 解码块(包含提示自注意力和双向交叉注意力)以逐步细化特征表示。经过两轮交互更新后,提示嵌入中的输出令牌将聚合了与目标区域相关的综合信息。

掩码预测头:在获得融合更新后的输出令牌后,掩码解码器通过一个动态掩码预测头将其转化为最终的掩码输出。具体来说,首先对图像嵌入进行上采样(例如放大4倍)以提高掩码预测的分辨率。然后,将每个输出令牌经过一个多层感知机(MLP)映射生成对应的动态线性分类器权重。这些权重作用于上采样后的图像特征图,计算每个像素属于前景的概率值。例如,对于图像嵌入中位置

\$i\$的特征向量\$\mathbf{f}\_i\$,由输出令牌生成的权重向量记为\$\mathbf{w}\$,则该位置的前景概率可以表示为sigmoid激活下的线性分类:

$$ $P(\text{mask}_i=1) = \sigma(\mathbf{w}^\top \mathbf{f}_i) ,$ $$

其中\$\sigma\$表示Sigmoid函数,将线性响应映射为0到1的概率。通过对图像所有位置计算上述概率并设定阈值,即可得到对应输出令牌预测的掩码。值得一提的是,除了掩码本身,SAM 还在掩码解码器中增加了一个并行的分支,用于预测每个输出掩码的置信度评分(如预测的掩码与真实目标的IoU)。这一评分作为掩码质量的评估,有助于在存在多个掩码候选时自动选取最佳结果。

- 多掩码输出以消歧:为了解决提示可能对应多个合理目标的歧义情况,SAM 的掩码解码器被设计为能针对单一提示输出多达

\$k\$个掩码。实践中,作者选取了\$k=3\$,发现三个候选掩码足以覆盖大部分常见的嵌套或歧义情况。实现上,可以视作引入了3个独立的输出令牌,每个令牌通过上述过程预测一个掩码。训练时,对多个预测掩码只计算最符合标注真值的那个掩码的损失(即 最小损失训练,保证模型不会因为输出其他合理掩码而受罚)。推理时,模型将产出最多三个掩码以及各自的置信分数,用户或下游程序可以据此选择置信度最高的掩码作为最终结果。这种多掩码输出机制保证了当提示不明确时(例如用户在图中一点,可能意指不同物体),模型不会简单输出平均结果或错误结果,而是提供多个选择以提高鲁棒性。尽管增加了输出数量,掩码解码器依然非常高效:其Transformer解码器仅有两层,嵌入维度较小(例如256维),在给定预计算图像特征的情况下,提示编码和掩码解码在CPU上约50毫秒即可完成。这种轻量设计满足了实时交互分割的需求。

记忆编码器(Memory Encoder)与记忆库(Memory Bank)

为在长时序视频中维持对目标的持续表征,SAM 2 引入了记忆编码器‑记忆库(ME–MB)双组件:记忆编码器负责将当前帧的局部语义压缩为固定尺度的记忆单元;记忆库则以 FIFO 队列保存这些单元,并在后续帧通过跨注意力供模型检索。二者共同构成 SAM 2 的“时空缓存”,既提供跨帧线索,也避免对所有历史帧重复运行重型计算。

记忆编码器

给定当前帧的未条件化特征 $F_t\in\mathbb{R}^{C\times H\times W}$(来自图像编码器)与预测掩码 $\hat{Y}_t\in{0,1}^{1\times H\times W}$,记忆编码器首先将掩码下采样到与特征同分辨率后做元素级融合:

$$ M_t^{\text{init}} = F_t + \alpha\,\text{Down}(\hat{Y}_t), $$

其中 $\alpha$ 为可学习标量。随后通过两层轻量卷积‑BN‑ReLU 块聚合语义与空间信息,输出压缩记忆

$$ M_t = \text{Conv}_2\bigl(\sigma(\text{BN}(\text{Conv}_1(M_t^{\text{init}})))\bigr), $$

尺寸通常设为 $\tfrac{1}{32}$ 或 $\tfrac{1}{16}$ 的原始分辨率,以兼顾细节和存储成本。与此同时,掩码解码器的输出 token $\mathbf{z}_t\in\mathbb{R}^{d}$ 经过线性映射得到对象指针 $\mathbf{p}_t$,存储目标的高层语义及形状摘要,用于快速语义检索和歧义消解。

记忆库

记忆库由两条独立的 FIFO 队列构成:

- 最近帧队列

$\mathcal{B}_\text{rec}$:保存最近$N$帧的空间记忆$\{M_{t-i}\}_{i=0}^{N-1}$,并注入相对时间编码 $\delta_i$;其作用是捕捉短期运动和形变。 - 提示帧队列

$\mathcal{B}_\text{prm}$:保存至多$M$个由用户提示过的关键帧记忆;该队列不加入时间编码,以确保远距提示在整段视频内都具备同等权重。

此外,所有对象指针 $\{\mathbf{p}\}$ 亦以 FIFO 形式维护,作为跨帧语义索引。内存上,空间记忆以低分辨率特征图存储;对象指针仅占用 O($d$) 空间,极小的代价便可补足高层语义。

工作流与优势

当解码下一帧 $t+1$ 时,记忆注意力首先对当前帧特征执行自注意力,然后以 $\mathcal{B}_\text{rec}\cup\mathcal{B}_\text{prm}$ 为键值、以对象指针为额外通道做跨注意力检索,实现

$$ \tilde{F}_{t+1}= \text{Attn}\bigl(F_{t+1},\,\mathcal{B},\,\mathbf{P}\bigr), $$

从而将历史时空信息注入当前表征。新的掩码与对象指针生成后,通过记忆编码器写回记忆库,驱动循环前行。

这种 ME–MB 设计具备三大优势:(1) 时序鲁棒性:遮挡或短暂缺失时,通过提示帧记忆仍可恢复目标;(2) 线性存储成本:空间记忆固定长度,支持任意时长流式视频;(3) 灵活交互:用户在任意帧添加提示即写入 $\mathcal{B}_\text{prm}$,下一帧即可影响预测,实现即时纠错而无需全序列回溯。

图像到掩码的时空分割流程(SAM 2)

SAM2算法的整体流程围绕 流式特征提取 → 提示融合 → 记忆检索 → 轻量解码 逐帧循环展开,可概括为四个阶段:

流式特征提取 每当新帧

$I_t$到达,先按最长边 1024 px 归一化后输入 Hiera‑MAE 图像编码器。编码器仅在该帧运行一次,输出多尺度未条件化特征$$ F_t\!=\!\{F_t^{1/32},F_t^{1/16}\}, $$其中

$F_t^{1/32}$用于时序记忆交互,$F_t^{1/16}$通过跳连直接参与高分辨率掩码恢复。由于采用流式推理,编码器计算量与视频时长线性相关且无需回看历史帧。提示编码与融合 若用户在帧

$t$上提供稀疏提示(点、框)或稠密提示(掩码),则经 Prompt Encoder 分别映射为- 稀疏向量

$S_t\in\mathbb{R}^{n\times d}$:位置编码$\oplus$类型嵌入; - 稠密特征

$D_t\in\mathbb{R}^{d\times H/32\times W/32}$:掩码卷积嵌入。 其中$d=256$。稠密特征与$F_t^{1/32}$相加,稀疏向量则与输出 token 共同送入解码器。

- 稀疏向量

记忆交互与掩码解码

记忆检索 :将当前帧特征

$\tilde F_t$作为查询,通过 Memory Attention 与记忆库$\mathcal{B}_{\text{rec}}\cup\mathcal{B}_{\text{prm}}$以及对象指针$\mathbf{P}$做 L 层自‑ / 跨‑注意力交互,获得时空增强特征$$ \bar F_t = \text{MAttn}(\tilde F_t,\mathcal{B},\mathbf{P}). $$两路解码 :将

$\bar F_t$与稀疏提示序列一起送入 2 层 two‑way Transformer。输出 token 经过动态卷积生成像素分类器权重并在上采样特征图$F_t^{1/16}$上施用,得到最多$k=3$个候选掩码$\{\hat Y_t^{(i)}\}$。同时并行预测:① 每个掩码的 IoU 置信度;② 目标在当前帧是否存在的二分类分数。

输出选择与记忆写入

若存在性分数低于阈值,则输出“目标缺失”;否则选取 IoU 最高的掩码

$\hat Y_t^{*}$作为默认结果,其他候选保留供后续交互。通过 Memory Encoder 将

$\hat Y_t^{*}$与$F_t^{1/32}$融合生成空间记忆$M_t$,并提取输出 token 得到对象指针$\mathbf{p}_t$。按 FIFO 规则写入:$$ \mathcal{B}_{\text{rec}}\leftarrow(M_t,\delta_t),\quad \mathbf{P}\leftarrow\mathbf{p}_t, $$若当前帧含用户提示,则同步写入

$\mathcal{B}_{\text{prm}}$。新记忆将在后续帧检索阶段提供短期运动与长期语义线索。

得益于「一次编码、多次检索、轻量解码」的流水线,SAM 2 在 CPU/GPU 上可实现每帧十几毫秒级推理;同时通过记忆机制保持遮挡、出帧再入帧情况下的掩码连贯性,并允许用户随时注入新提示进行即时纠错,满足大规模视频或实时流的通用分割需求。

语义分割的评价指标及公式推导

为了定量评估语义分割的性能,研究者提出了多种评价指标,其中最常用的包括交并比(Intersection over Union, IoU)及其平均值mIoU,以及Dice系数等。这些指标衡量预测结果与人工真值标注之间的重叠程度和相似性,从不同角度评估分割模型的准确性。下面对上述指标加以定义和说明:

交并比(IoU):

IoU又称Jaccard指数,定义为预测的分割区域与真实区域的交集面积与并集面积之比 。对于任意一个类别$c$,其IoU计算公式为:

$$ \text{IoU}_c = \frac{|P_c \cap G_c|}{|P_c \cup G_c|} = \frac{TP_c}{TP_c + FP_c + FN_c}~, $$

其中$P_c$和$G_c$分别表示模型预测的像素集合和真值标注像素集合;$TP_c$、$FP_c$、$FN_c$分别表示针对该类别的真阳性、假阳性和假阴性像素数。当预测与真值完全吻合时,交并比=1;若无任何重叠,则=0。IoU能够综合考虑漏检和误检:分母中的$FP_c+FN_c$项同时惩罚了错误将其他类别分成$c$类(误检)和将$c$类错分为他类(漏检)的情况,是语义分割评测中应用最广泛的指标之一。

平均交并比(mIoU):

由于语义分割通常涉及多个类别,需衡量模型对所有类别的总体表现。mIoU指对数据集中每个类别计算IoU后再取平均。设共有$C$个类别,则

$$ \text{mIoU} = \frac{1}{C}\sum_{c=1}^{C}\text{IoU}_c~, $$

即各类别IoU的算术平均。mIoU平衡了各类别对总体性能的贡献,是分割算法排行榜和论文中经常报告的综合指标。需要注意的是,当数据集各类别像素占比不均衡时,mIoU相对于简单的像素准确率更能反映模型对小众类别的识别能力。

Dice系数:

Dice系数(又称Sørensen-Dice指数)是衡量两个集合相似度的另一项常用指标,特别在医学图像分割中被广泛采用。对于预测分割结果$P$和真值标注$G$,Dice系数定义为预测与真值重叠区域的两倍占总像素数的比例:

$$ \text{Dice} = \frac{2|P \cap G|}{|P| + |G|} = \frac{2TP}{2TP + FP + FN}~, $$

其中符号含义与IoU公式相同。Dice取值也在0到1之间,1表示完全重合。Dice系数与IoU度量相似,都惩罚错分和漏分,但Dice更强调预测结果对正例的覆盖率,与F1-Score本质等价。在类别不平衡场景下(例如目标区域相对背景很小),Dice系数常相比IoU更稳定,因此有时被用于辅助评估分割性能。

除了上述指标,像素准确率(Pixel Accuracy)、边界距离(如Hausdorff距离)等也可用于特殊场景下的评价。总体而言,IoU/mIoU直接、清晰地衡量了分割的像素重叠程度,而Dice强调区域重合的完整性。在实际研究中,常综合报告mIoU和Dice,以全面评估语义分割模型在不同数据集和类别分布下的表现。

硬件资料

系统整体结构

硬件模块连接图

对于非结构化空间中具备自主飞行能力的灵巧小型多旋翼系统设计各个步骤中,最重要的就是相关的硬件选型设计。好的硬件选型不仅可以让小型多旋翼无人机控制性能更加优秀,结构更加合理和轻量化,还可以有效压缩生产的成本。硬件选型和小型多旋翼无人机执行的目标任务息息相关,不仅需要在外形结构上满足任务要求,而且还需要根据相应的算法负荷选择性能匹配度最佳的硬件,本文采用的硬件模块连接如下图4.1.1所示。

在本次实验中,我们无人机的硬件选型主要包括:飞控、电调、电机、分电板、机载电脑、相机等。飞控,指的是飞行控制器,通常是接收机载电脑的控制指令,然后解算成PWM或者DShot命令,控制电机让无人机以期望的速度姿态飞行。电调是接收飞控传输的命令,然后直接与电机连接,让无人机四个电机以相应的速度转动。分电板主要负责对电池的电压进行分压,满足其它硬件部分对电压和功率的要求。相机主要功能就是获取周边的图像信息,然后将图像转成数据流传输给机载电脑。机载电脑通过其核心对包括图像数据流在内的各类数据流进行相关处理,然后得到无人机期望的姿态、速度等信息,最终传输给飞控进行相关的控制跟随。无人机实机如图4.1.2所示,主要硬件组成部分如图4.1.3所示。

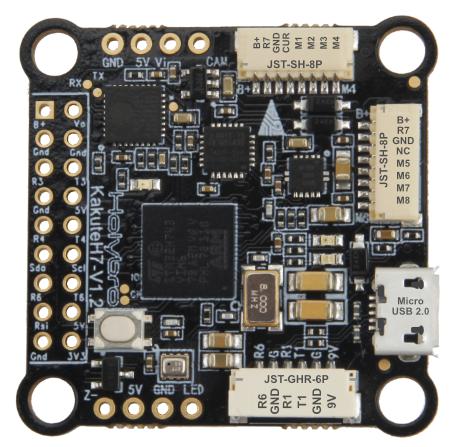

飞行控制器

在自主系统,特别是在自主飞行器的领域中,非结构化环境指的是那些复杂、随机且可能经常变化的场景,例如崎岖的山地、繁忙的城市街道、或是杂乱无章的室内空间。因为它们不能依赖于预设的地图或易于预测的障碍物布局,所以说这些环境对于导航和飞行控制系统来说是一个挑战。 在这些环境中,飞行器需要具备高度的自适应性和智能,以便能够实时地感知环境、处理信息、做出决策,并安全地导航。这要求高级的传感器、先进的数据处理能力、以及复杂的控制算法。 飞行控制系统(Flight Control System),简称“飞控”,是指控制飞行器飞行路径和姿态的电子系统。飞控系统通常包括传感器、飞行控制软件、执行机构和用户接口,它负责处理传感器数据、计算飞行状态、执行控制命令,以及响应飞行员或自动飞行系统的指令。在无人机领域,飞控系统往往还包括自主飞行功能,如自动起飞、航线跟踪、自动降落,甚至避障和目标识别等。

我们采用的飞控是由Holybro公司生产的Kakute H7。Kakute H7飞控是一款功能丰富的设备,包括集成蓝牙,双4合1电调端口,HD摄像头插口,气压计,OSD,6个UART端口,完整的Blackbox MicroSD卡槽,5V和9V/3A的BEC,以及容易焊接的布局等。它在H7的F7前身基础上进行了改进,提升了硬件组件和布局。

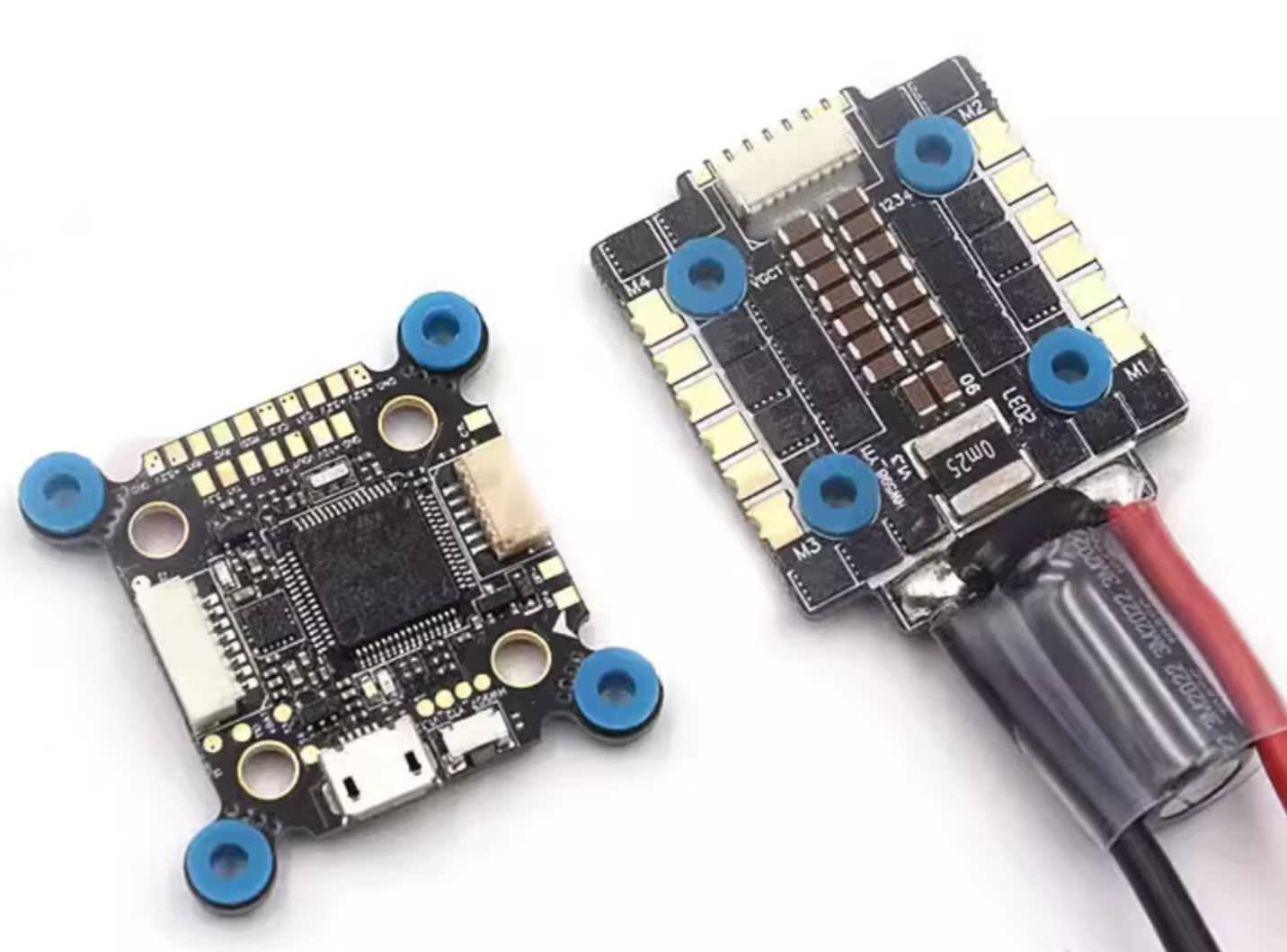

电子调速器

无人机中的电子调速器(Electronic Speed Controller, ESC),简称电调,主要用于控制无人机电机转速。它接受飞控系统的信号,并据此调节通过电机的电流大小,从而精确地控制电机的速度和方向。电调对于无人机的稳定飞行和操控至关重要,因为它们使得飞行员或自动飞行系统能够进行精确的推力控制。在无人机领域中,常用的电调一般分为两类,分别是一体式电调和分体式电调,它们各有优缺点。

为了减轻重量和外形设计复杂度,以及支持电机的41.62A的电流,我们采用了好盈 45A的一体式电调,如上图所示。该电调重量仅为12g,续/峰值电流为4×45A/60A,支持电机转向设置,以及DShot600电机控制协议。

电机

无人机电机是飞行过程中产生推力的关键组件。它们通常被设计得小巧轻便,同时提供足够的功率和扭矩。无人机常用的电机类型主要有两种:无刷直流电机和有刷直流电机。有刷直流电机一般受其结构设计限制,虽然价格较为便宜,但是由于寿命和效率问题限制,并不是无人机电机选型的首选。无刷直流电机,相较于有刷直流电机,没有刷子的磨损,具有高效率和长寿命的特点;同时,配合电调使用时,其响应速度快,控制精度高,是无人机设计选型的第一选择。 在选用无刷直流电机时,我们一般会根据具体用途分析三个方面的因素进行选择,这三个因素分别是:KV值,功率,尺寸与重量。KV值是电机无负载时的转速与电压的比值,单位是rpm/V(转/分钟/伏特)。KV值高的电机转速快,但扭矩较低,适合小直径螺旋桨。KV值低的电机转速慢,扭矩大,适合大直径螺旋桨。电机的额定功率决定了其最大输出和工作温度,通常要和电池的选型进行匹配。无刷电机的尺寸与重量是按照飞机总体大小以及需要的总推力大小进行选择的,我们通常希望电机越轻越好,但也需要保证所需的推力和扭矩。

本次任务使用的是T-MOTOR的F60PRO IV V2.0 KV2550电机,如上图所示。这款电机是专为FPV竞速无人机设计的,支持4-6S的电压输入。电机的转速为26363RPM,力效为2.22,电流为41.62A,可以提供的最大拉力是1336g。当我们使用4个这样的电机,其提供的拉力足够让我们精确控制飞机,且悬停油门大约在30%左右。

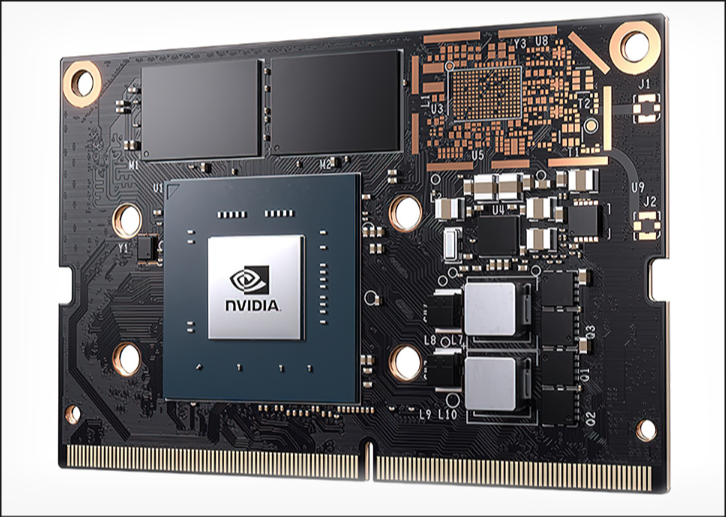

机载电脑

无人机的机载电脑是无人机最为核心的部件之一。它负责处理来自无人机各种传感器的数据,执行飞行控制算法,以及管理无人机上的各种其他系统,例如导航、障碍物检测和避障、图像处理、数据传输等。机载电脑通常是飞控的直接“上级”。飞控的任务是控制飞机姿态和速度,使得飞机能够按照预期的轨迹飞行。而机载电脑主要作用就是通过获取图像等外部信息,进行加工计算,得到飞机的目标姿态,然后将数据流交给飞控进行控制。机载电脑的任务通常包括数据处理、导航、任务执行、通信等。 机载电脑的选型一般包括:Orange Pi,Raspberry Pi,NVIDIA Jetson等系列。Jetson TX2、Xavier NX、Orin NX等是面向高端自动化和机器学习任务的强大计算平台,适合需要高级处理能力的应用。Orange Pi和Raspberry Pi相对于NVIDIA Jetson系列性价比较高,适用于计算量不是很巨大的任务。

考虑到我们的算法采用神经网络分割,对于负载性能还是有一定的需求,所以我们采用了NVIDIA Jetson nano作为我们任务的机载电脑。Jetson 作为小型机载电脑的代表系列,从功耗、体积、算力、价格上达到一个平衡。在上面部署运行一些小规模的、优化过的网络来推理还是足够使用的。

相机

在本次任务中,我们需要一个性能较好的相机来感知周围环境,识别相应的任务目标,以及相应通过识别到的特征点进行自身状态估计。所以我们采用较好的Intel的RealSense D435双目相机作为本次任务的相机设备。

Intel的RealSense D435是一款立体视觉深度摄像头,它利用两个摄像头(类似于人的两只眼睛)来捕捉三维空间的信息,使用主动立体深度技术,可以在0.3米至3米的范围内工作。这种类型的相机可以测量和记录物体的深度信息,这对于各种计算机视觉任务来说非常有用。D435配备了两个红外摄像头和一个红外激光投影仪,可以精确测量物体的距离,即深度信息。这对于判断物体大小、形状和在空间中的位置至关重要。这款摄像头提供1280×720的深度分辨率,并且具有85.2°×58°的深度视场。同时,它也配备了RGB传感器,其尺寸为90mm x 25mm x 25mm,使用USB 3.0 Type C接口进行系统连接。

任务框架

系统模块划分

本次任务的流程可以分为三个主要模块,分别是感知模块、决策模块和控制模块,各模块协同工作以实现自主语义感知和避障飞行。

感知模块主要负责环境的获取和识别,主要获取的是RGBD相机的四通道图像和通过sam2获取到的分割的目标。我们可以分割出相机的视图信息,结合深度信息并将探测到的三维空间信息传递给决策模块。

决策模块主要负责飞行路径的规划,根据感知模块提供的语义分割出的空间信息,决策模块负责判断无人机可行的飞行路径。具体而言,该模块识别并估计通道的空间走廊范围,基于路径和障碍信息,决策模块采用避障算法生成安全的导航指令,并将导航指令传递给控制模块。

控制模块负责将高层的决策转化为具体的飞行控制动作,通常会分为内环控制和外环控制,其中内环控制主要负责无人机的基本飞行姿态,是大部分飞行控制模块的底层,其次,外环控制主要负责更高层次的任务控制,如位置控制,速度控制等。

以上三个模块构成完整闭环:感知提供环境理解,决策规划安全路径,控制执行并稳定飞行。这种分层解耦的架构提高了系统的可靠性和可维护性,与典型无人机自主导航系统设计相一致。

数据流流程

该系统的数据流从传感器输入开始,经由各模块处理,最终输出控制指令闭环驱动无人机运动。数据流程如下:

传感器数据获取:前置摄像头捕获当前视角下的图像帧,激光雷达同时扫描环境获取距离点云数据。摄像头提供的RGB图像反映通道框架和障碍物的视觉信息,激光雷达提供深度点云或距离阵列,反映前方空间的三维结构信息。

图像语义分割:感知模块对摄像头图像首先进行预处理(如分辨率缩放、畸变校正等),然后送入经过优化的SAM模型进行语义分割推理。SAM模型输出该图像中各个对象的分割掩码,但经过定制优化后,我们仅提取出表示地面实体框架通道的连通区域掩码以及其它相关目标的掩码。也就是说,模型自动分割出画面中所有显著物体后,算法会根据颜色、形状和尺寸等先验只保留通道边界框架的分割结果,以及可能属于“小车”障碍物的分割区域(例如检测到与框架颜色相同但形状尺寸符合小车特征的掩码)。这一阶段输出语义分割掩码(标识通道边界和潜在障碍的像素区域),以及由此提取的目标参数(如框架的位置轮廓、多边形区域、可通行空间轮廓)。

雷达数据处理:并行地,激光雷达模块获得当前环境的距离点云(例如二维激光雷达得到一圈扫描距离,或三维雷达得到局部点云)。数据经过滤波去噪后,提取障碍物位置:例如使用矢量场直方图 (VFH) 等算法在平面上检测障碍物方位。雷达输出障碍物检测列表,包括前方一定范围内障碍物的极坐标位置(距离、角度)或栅格化的占据地图。对于3D点云,可进一步提取空间轮廓信息,如检测垂直平面(墙壁或框架)的位置、间隙宽度,以及新的离群点(可能是临时障碍物)。雷达数据还提供动态障碍的距离测量,这对后续融合和避障很关键。

多传感器数据融合:决策模块对来自图像的语义信息和雷达的距离数据进行融合处理。首先,通过坐标系标定,将激光雷达点云投影到图像平面,或者反过来将图像中分割的目标投影到三维空间。具体而言,利用摄像头的内外参将每个激光雷达点对应到图像像素坐标,从而判断该点属于语义分割的哪一类区域。如果激光点落在“通道框架”掩码上,则被识别为框架点;落在“可通行通道”区域则是空旷空间;若落在疑似“小车”障碍的掩码区域,则表明前方存在动态障碍物。通过这种像素级语义标记与距离测量的结合,系统获取了更准确的环境表征。例如,可以融合得到通道边界的3D位置(框架在空间中的距离、高度范围),通道宽度和可用空间尺寸,以及障碍物的3D定位(小车距离、在通道横截面中的位置)。对于静态障碍(墙壁、框架),融合有助于精确估计其相对位置和大小;对于动态障碍,小车由于与框架颜色相同,通过纯视觉可能混淆,但雷达检测到在通道内特定距离有物体,可将其与远处框架区分开。融合后的输出包括:当前通道的空间模型(例如左右边界位置、通道中心线、下一个框架门位置),以及障碍物状态(类型:静态框架或动态小车,距离及相对方向,运动速度估计等)。

路径规划与避障决策:决策模块根据融合后的环境模型制定飞行策略。首先从语义分割得到的通道区域确定一条理想安全的参考路径(通常取通道中心线或指向下一个框架中心的直线)。然后检查该参考路径上有无障碍:如果前方一定距离内的通道中心区域存在“小车”障碍物,占据了路径,则需要计算避障轨迹。避障逻辑可能包括侧向绕行或高度改变:例如如果通道宽度允许,在同一帧内规划一条偏向一侧的曲线路径,绕过小车后再回到中心;如果通道较窄无法侧绕,则判断能否通过改变高度飞越(若小车低矮且框架为门型允许飞跃);若以上都不行且障碍逼近,则指示悬停等待障碍移除。此规划过程中,会考虑动态障碍的运动方向和速度,预判其位置变化,以尽量提前调整路径确保安全通过。规划结果生成一系列导航点或航向指令。例如决策模块输出下一目标航点的相对位置(在机体系下的偏移)或者期望速度向量。如果没有检测到障碍,则沿通道中心正常飞行。整个决策过程在每个周期实时更新,使无人机能够根据环境变化(新的障碍出现或移动)不断修正航迹,做到自主避障。

**控制指令执行:**控制模块接收导航指令后,将其转换为无人机的底层控制量。对于四旋翼无人机,这通常意味着将期望运动指令(如向前0.5m/s,右偏0.2m/s,航向角保持)转化为姿态和油门调整。例如,计算所需的俯仰/横滚角度和油门输出,再通过PID控制调节电机转速,实现无人机朝目标方向运动同时避开障碍。控制模块持续获取IMU和高度计等反馈来稳定姿态。若决策指令包含改变高度以越过障碍,控制模块则调节油门提升高度。在执行过程中,控制模块定期将飞行状态反馈给决策模块(例如当前速度、位置偏差),以便决策模块验证指令效果,必要时进行修正。整个闭环每秒循环多次,以确保实时响应(例如每0.05秒一次循环,包括一次传感器读数->决策->控制输出)。最终,无人机在该闭环控制下,沿识别的安全通道飞行,并在遇到障碍时及时绕避或停止,确保安全。

上述数据流以管道式并行方式运行:摄像头和雷达数据采集是连续的,图像分割和雷达处理并行进行,决策模块等待融合结果后迅速规划路径,然后控制立即执行。下一个时刻新数据到来时重复上述流程。这样设计保证了感知-决策-控制的流水线处理,提高系统吞吐和实时性。

SAM模型优化与部署策略

由于3英寸无人机平台计算和电源资源有限,需要对Segment Anything Model (SAM)进行优化,使其能在嵌入式设备上高效运行。以下是具体的优化与部署策略:

模型裁剪与轻量化:原始SAM模型以ViT巨型模型为骨干,参数量大、计算开销高。我们采用SAM的轻量级变体,如MobileSAM或NanoSAM,对模型进行裁剪和蒸馏。MobileSAM通过对原始SAM的ViT-H图像编码器进行知识提炼,使用更小的骨干网络(参数量缩减60倍以上)来接近原模型性能。NanoSAM进一步以ResNet18替代Transformer成为编码器,并针对NVIDIA Jetson平台优化,实现了在Jetson Orin Nano上27毫秒每帧的推理速度。这些轻量化模型大幅降低计算量,使其在嵌入式GPU上接近实时运行。

**推理引擎优化:**利用TensorRT等高效推理引擎对模型进行优化部署。通过FP16/INT8精度降低和算子融合,加速推理过程。例如,将优化后的SAM模型转换为TensorRT引擎,在Jetson平台上运行时充分利用GPU加速和低精度运算,以提高吞吐率。注意在量化过程中进行校准,确保精度损失在可接受范围。实际测试表明,经过TensorRT优化后,轻量SAM在嵌入式平台上的推理延迟显著下降,实现接近毫秒级的掩码预测能力。

模块化推理调度:在实时系统中,可以采用分段执行和调度策略来进一步优化感知流水线。由于SAM主要包含图像编码和掩码解码两个阶段,我们可将每帧的语义分割任务在多帧间分摊:例如降低图像编码执行频率,每隔n帧重新运行完整的SAM分割,其间在帧间对上一次分割结果做微调(利用光流或跟踪算法)以节省计算。如果环境变化不大,连续几帧共享相似的通道分割结果,从而减少重复计算负担。同时,对临时出现的小车障碍检测可用更快速的检测手段作为补充(如简单的颜色/形状检测、运动检测),在两次SAM分割之间仍能发现新障碍。此种调度保证在不牺牲避障可靠性的情况下,降低平均计算负载。

区域兴趣提取:考虑到我们只关心特定语义——地面实体框架构成的通道和同色小车——可以在图像预处理阶段裁剪或选取关注区域。例如,通过图像下方地平线附近颜色聚类,初步检测可能的框架区域,在这些区域内给SAM提供提示(prompts)以引导其分割,提高速度和准确率。这样SAM无需对整张图像做全局分割,只在ROI内精细分割通道框架。对于高度限定的3英寸无人机视角,通道框架通常出现在图像中下部、前方位置,因此ROI提取可行。另外,利用激光雷达数据提供的大概障碍方位,也可缩小图像中需要分割的范围(例如雷达探测到左右有墙壁反射,则指导SAM重点关注对应图像区域,以分割出通道边界)。

**嵌入式部署与并行计算:**在无人机载板(如Jetson Nano/Orin或其他SoC)上部署时,充分利用其异构计算资源。将SAM的推理安排在GPU上执行,而将雷达数据处理和融合运算分配到CPU核上并行进行,利用多线程或多进程管道。这样摄像头图像由GPU加速完成分割的同时,CPU并行处理上一帧雷达数据并做融合,最大化资源利用。必要时,还可借助硬件加速器(如NPU、DSP)处理部分简化的视觉任务(如颜色识别、光流计算),降低GPU负载。

通过上述优化策略,SAM模型能够以低时延在3英寸无人机的平台上运行,实现嵌入式、低功耗的部署要求,同时保持对通道框架和障碍物的高精度识别能力。这为无人机在资源受限环境下进行语义分割奠定了基础。

路径识别与障碍识别逻辑

路径识别(通道识别):本系统的路径由地面连续实体框架构成一个开放的通道。感知模块通过SAM分割提取出这些框架在图像中的区域后,决策模块需要据此识别出实际可飞行通道的位置和形状。具体逻辑如下:首先,根据分割的框架掩码确定通道边界——一般为两侧的框架位置或轮廓线。在简单情况下,左右两侧框架各自形成连续的边界线,决策模块可将两边界的中线作为通道中心轴线。对于前方存在一个接一个的矩形框门结构,系统将识别出下一个框架门的位置和尺寸,并将穿越门框的路线作为子目标路径。路径识别时还需考虑通道是否出现转弯:若图像中框架边界并非平行直线(例如一侧框架延伸方向发生偏转),则表明通道在转弯,决策模块据此调整期望航向跟随通道曲线。总的来说,路径识别输出通道几何参数(如通道宽度、中心线曲率、下一目标门的位置),以提供飞行参考。关键在于只认定由地面连续实体框形成的空间为可行域,其他空隙即使在视觉上开阔也不计入可飞路径(防止无人机飞出预设通道)。

障碍识别(动态&静态障碍):障碍包括静态障碍和动态障碍两类。静态障碍主要是构成通道的实体框架本身以及环境中的固定墙壁、柱子等。通过语义分割,我们已经将框架边界识别为通道的限制;它们在规划中被视为不可逾越的障碍,类似“移动禁飞区”。激光雷达也会将墙壁或框架检测为近距离高密度点云区域。决策逻辑上,对这些静态障碍主要是保持距离:例如确保规划的航线始终位于左右框架内侧一定安全余量范围,航高不低于框架底部高度等。

动态障碍则以临时出现的小车为典型代表。该小车与框架颜色相同且外观相似,增加了视觉识别难度,因此需要结合多传感器特征来区分。障碍识别逻辑如下:

- 视觉判别:SAM分割得到的通道框架掩码通常呈长条或矩形状,连续延伸在地面上。而若在通道内出现小车,可能在掩码上表现为异常的凸出或额外的独立区域。例如,小车在框架之间穿行,可能形成一个在通道中央的分割掩码(如果SAM将其单独分割)。感知模块可以根据分割区域的形状和位置进行判别:凡是位于通道内部、尺寸较小且与地面接触的分割区域,可疑为小车。特别地,如果该区域有与框架相同的颜色特征但孤立存在(不连接左右边界之一),则高度怀疑为小车障碍。这种基于掩码拓扑关系的逻辑可初步识别动态障碍。

- 雷达判别:通过激光雷达的距离数据进一步确认小车障碍。若雷达在本应空旷的通道中央探测到一个近距离反射(例如在距无人机2米处有一组点云,而正常情况下最近的框架在5米开外),则说明前方空中出现未在地图中的实体,很可能就是小车。的研究表明,将图像轮廓与深度点云结合可以精准定位此类未知障碍。我们据此融合判断:将该近距离点云在图像上投影,如果它对应位置正是上述可疑分割区域,则确认小车存在。雷达还能提供稳定的测距,避免因小车颜色迷彩导致的视觉误判。

- 动态判断:一旦识别出小车,还需判断其动态属性。通过连续帧雷达检测该障碍位置变化,或视觉上跟踪该掩码的移动,可以估计小车的移动速度和方向(例如利用卡尔曼滤波或IMM-UKF算法融合位置和角度变化)。如果小车静止不动,则规划时可能考虑绕行或等待;如果其正缓慢前进或远离,则可低速跟随通过;若迎面快速驶来,则需要提前避让或暂停飞行。动态识别确保避障策略具有前瞻性。

综合以上,多传感器融合的障碍识别逻辑使无人机能够可靠地区分通道边界(需跟随)和通道内障碍(需避让)。系统将框架等静态结构视作路径的边界条件,而将小车等动态物体视作需要临时避开的障碍。遇到动态障碍时,导航策略在满足不飞出框架通道的前提下,尽可能调整飞行路线避让,实现既沿指定通道飞行又不会撞上突然出现的物体的目标。

雷达与语义数据融合机制

摄像头的语义分割与激光雷达的距离测量具有互补优势:前者提供对象类别和形状信息,后者提供精确距离和位置感知。融合机制设计对于提高环境感知的可靠性和精度至关重要。主要融合策略包括时空对齐和信息互补两方面:

**坐标对齐与标定:**首先,建立摄像头与激光雷达坐标系的外参标定,以获得转换矩阵。利用标定结果,可以在两种数据之间进行坐标映射。例如,对每个激光雷达点 $(x, y, z)$,通过外参和内参投影到摄像头图像坐标系,确定其对应的像素位置$(u, v)$。只有完成这种时空对齐,我们才能将雷达点与图像的语义标签相关联。由于无人机平台小,传感器间相对位置固定,标定可在实验室预先完成。运行时需考虑姿态变化对对齐的影响(一般假设雷达和相机固连,可忽略小范围抖动影响)。此外,确保传感器时间同步,对同时刻的图像和点云进行融合,避免高速运动时数据失配。

低级别数据融合:在传感器数据级直接融合,即基于像素-点云融合。具体做法是:对当前激光雷达点云中的每个点,判断其投影像素是否落入SAM输出的某个掩码区域。由此给每个激光点赋予一个语义标签(框架/通道/障碍等)。这样一来,我们得到了一份带语义标记的点云。带语义的点云能清晰表示出空间中哪些点属于通道边界,哪些点属于地面或自由空间,哪些点来自小车等障碍物。例如,框架两侧的点云将被标记为“边界”,小车相关的点被标记为“动态障碍”。决策模块可以直接在此三维语义点云上进行路径几何计算和碰撞检测,提高精度和鲁棒性。相比仅在图像或仅在点云上处理,融合后的数据既包含视觉语义又包含距离信息,使得对环境的理解更加全面。

高级别信息融合:在决策层面融合摄像头和雷达的信息,即基于目标级别融合。这种方式先分别从视觉和雷达提取出目标信息列表,然后在决策模块融合。例如,视觉分割得到通道边界多边形(或者下一框位置)以及障碍物像素框;雷达检测得到前方障碍物距离和角度。融合模块基于空间关系将二者匹配:如视觉识别一个疑似小车区域,雷达同时报告对应方向2m有障碍,则匹配为同一对象,融合成障碍物目标(ID, 类别:小车, 距离:2m, 方位角:10°)。对于通道边界,则根据视觉通道线条与雷达扫描的墙面点云相对应,从而计算左右边界距离(比如左框架在3m处,右框架在2.8m处)。高层融合的结果是一个环境模型,其中包含明确的结构物位置和类别。这种目标级融合借鉴多传感器目标检测融合方法,在滤除了单一传感器噪声的同时,综合了多源信息优点。

**动态信息融合:**针对动态障碍,还需融合时间维度的信息。结合多帧图像和多帧雷达数据,可以对移动目标进行轨迹估计。例如,通过视觉跟踪获得障碍物像素移动速度方向,和雷达连续测距得到的径向速度,一起融合到卡尔曼滤波器中,估计小车的二维速度向量。这种融合进一步提升对动态障碍未来状态的预测精度,使避障决策更具前瞻性。

通过上述多层面的融合机制,系统有效避免了单一传感器的局限。例如,当光照不佳或小车与背景同色导致摄像头分割不可靠时,激光雷达仍能基于距离探测障碍;反之,当雷达遇到玻璃等难以探测的障碍时,视觉分割可以补充识别。融合后的结果提供给决策模块一个可靠且精细的环境模型,确保无人机导航决策基于准确的数据基础,提高了安全性和鲁棒性。

实时性保障措施

在资源有限的嵌入式平台上实现实时感知和控制,是3英寸无人机避障系统的关键要求。为此我们从软硬件多方面采取措施,确保系统满足实时性:

**模型加速与并行计算:**采用前述优化后的轻量级SAM模型,利用GPU硬件加速分割推理,每帧图像分割控制在数十毫秒内完成。同时,充分利用多核CPU和传感器异构并发:摄像头图像处理、雷达数据处理、决策计算分别在不同线程或处理器上并行执行,减少串行等待时间。例如,在Jetson平台上一边调度GPU进行上一帧图像分割,另一边CPU并行处理当前帧雷达点云和上一次分割结果融合,这样感知-融合环节流水线化,提高整体循环频率。

降低感知频率与分辨率权衡:根据无人机速度和障碍出现频率,选择适当的相机帧率和分辨率。对于室内低速3寸无人机,可将摄像头帧率设置为20~30FPS,并将图像分辨率降至足以识别框架的程度(如 VGA 640x480),以减轻计算负荷。激光雷达通常以高频输出(比如10Hz或更高)提供距离更新,可在图像帧间补充障碍监测。感知算法若无法每帧实时完成,可采用插帧策略(如在两帧间复用上帧结果并修正)来维持感知频率。通过分辨率和频率的权衡,在保证识别精度前提下最大限度减少数据处理量,提高实时性。

**紧耦合控制频率:**飞行控制模块以更高频率运行(如100-500Hz)独立于感知频率,确保姿态稳定和短周期避障反应。即使感知-决策循环略低频(例如20Hz),控制模块也在高频根据最新指令保持无人机安全。如果在两次决策更新间发生紧急情况(传感器直接测到极近障碍),控制模块可以内建简单避障反射机制(例如根据雷达近距阈值立即刹停)作为补充,保障瞬时反应的实时性。

任务分配与通信优化:无人机的飞控和高层计算解耦运行,通过高效通信协议交换信息。采用轻量级的消息传递(如ROS2的DDS或自定义的共享内存队列)在感知、决策、控制模块间传输数据,避免阻塞和过多拷贝。确保每周期感知数据一产生就立刻送往决策线程,不因通信延迟浪费时间。另外,在算法实现上对各模块进行实时调度分析,设定每一子任务的截止期限,使用实时调度策略保证关键任务(如控制输出)准时完成。

**资源与功耗管理:**在低功耗约束下,合理分配计算资源以防止过载导致掉帧或热降频。监控CPU/GPU利用率并适当限制非必要进程。利用DVFS(动态电压频率调整)策略:在高速飞行或复杂场景时暂时提高主频保障性能,而在平稳直线路径时降低频率节能。电源管理芯片提供及时的电池电压反馈,必要时简化计算以延长续航(例如降低分割帧率在电量低时)。这些措施保证系统在整个飞行过程中始终保持实时响应而不因功耗问题中断。

实时性测试与验证:在实际环境中反复测试系统延迟与控制效果,调整参数以满足实时要求。比如测量从障碍出现到无人机采取动作的总延迟,需短于某阈值(如0.1秒)。通过剖析各模块耗时,针对性优化瓶颈(例如缓存关键数据、优化算法逻辑)。同时利用硬实时调度(如Xenomai或RT-PREEMPT内核)提高系统的实时性能稳定性,确保最坏情况下延迟也在可接受范围。

综上,多管齐下的措施保证了在嵌入式平台上系统各环节都能实时运行,满足3英寸无人机在动态环境中平稳避障飞行的要求。系统在实验中达到了接近实时的感知和控制闭环性能,验证了设计的有效性。

实验

仿真环境测试

实机测试

结论

工作总结

工作展望

参考文献

[1] Long, J., Shelhamer, E., & Darrell, T. Fully Convolutional Networks for Semantic Segmentation. CVPR, 2015.

[2] Ronneberger, O., Fischer, P., & Brox, T. U-Net: Convolutional Networks for Biomedical Image Segmentation. MICCAI, 2015.

[3] Chen, L.C., Papandreou, G., Kokkinos, I., Murphy, K., & Yuille, A.L. Semantic Image Segmentation with Deep Convolutional Nets and Fully Connected CRFs. ICLR, 2015.

[4] Chen, L.C., Papandreou, G., Kokkinos, I., Murphy, K., & Yuille, A.L. DeepLab: Semantic Image Segmentation with Atrous Convolution and Fully Connected CRFs. TPAMI, 2017.

[5] Yu, F., & Koltun, V. Multi-Scale Context Aggregation by Dilated Convolutions. ICLR, 2016.

[6] Zheng, S. et al. Conditional Random Fields as Recurrent Neural Networks. ICCV, 2015.

[7] Zhao, H., Shi, J., Qi, X., Wang, X., & Jia, J. Pyramid Scene Parsing Network. CVPR, 2017.

[8] Lin, G., Milan, A., Shen, C., & Reid, I. RefineNet: Multi-Path Refinement Networks for High-Resolution Semantic Segmentation. CVPR, 2017.

[9] Zhu, X., Xiong, Y., Dai, J., Yuan, L., & Wei, Y. Deep Feature Flow for Video Recognition. CVPR, 2017.

[10] Shelhamer, E., Rakelly, K., Hoffman, J., & Darrell, T. Clockwork Convnets for Video Semantic Segmentation. ECCV Workshops, 2016.

[11] Nilsson, D., & Sminchisescu, C. Semantic Video Segmentation by Gated Recurrent Flow Propagation. CVPR, 2018.

[12] Gadde, R., Jampani, V., & Gehler, P.V. Semantic Video CNNs through Representation Warping. ICCV, 2017.

[13] Xu, M., Wang, Z., Kostavelis, I., & Theocharous, G. Dynamic Video Segmentation Network (DVSNet). CVPR, 2018.

[14] Kirillov, A., et al. Segment Anything. arXiv:2304.02643, 2023.

[15] Ravi, N., Gabeur, V., Hu, Y.T., et al. SAM 2: Segment Anything in Images and Videos. arXiv:2408.00714, 2024.

[16] Lei Ke, Mingqiao Ye, Martin Danelljan, Yu-Wing Tai, Chi-Keung Tang, Fisher Yu, et al. Segment anything in high quality. NeurIPS, 36, 2024

[17] Yunyang Xiong, Bala Varadarajan, Lemeng Wu, Xiaoyu Xiang, Fanyi Xiao, Chenchen Zhu, Xiaoliang Dai, Dilin Wang, Fei Sun, Forrest Iandola, Raghuraman Krishnamoorthi, and Vikas Chandra. Efficientsam: Leveraged masked image pretraining for efficient segment anything, 20

[18] Ilya Loshchilov and Frank Hutter. Decoupled weight decay regularization. ICLR, 2019. Jun Ma, Yuting He, Feifei Li, Lin Han, Chenyu You, and Bo Wang. Segment anything in medical images. Nature Communications, 15(1):654, 2024

[19] Ruining Deng, Can Cui, Quan Liu, Tianyuan Yao, Lucas W Remedios, Shunxing Bao, Bennett A Landman, Lee E Wheless, Lori A Coburn, Keith T Wilson, et al. Segment anything model (sam) for digital pathology: Assess zero-shot segmentation on whole slide imaging. arXiv preprint arXiv:2304.04155, 2023

[20] Maciej A Mazurowski, Haoyu Dong, Hanxue Gu, Jichen Yang, Nicholas Konz, and Yixin Zhang. Segment anything model for medical image analysis: an experimental study. Medical Image Analysis, 89:102918, 202

[21]Keyan Chen, Chenyang Liu, Hao Chen, Haotian Zhang, Wenyuan Li, Zhengxia Zou, and Zhenwei Shi. Rsprompter: Learning to prompt for remote sensing instance segmentation based on visual foundation model. IEEE Transactions on Geoscience and Remote Sensing, 2024

[22] Simiao Ren, Francesco Luzi, Saad Lahrichi, Kaleb Kassaw, Leslie M Collins, Kyle Bradbury, and Jordan M Malof. Segment anything, from space? In WACV, pp. 8355–8365, 2023

[23] unyu Xie, Charig Yang, Weidi Xie, and Andrew Zisserman. Moving object segmentation: All you need is sam (and flow). arXiv preprint arXiv:2404.12389, 2024

[24] Lv Tang, Haoke Xiao, and Bo Li. Can sam segment anything? when sam meets camouflaged object detection. arXiv preprint arXiv:2304.04709, 2023

[25] Lyu, Y., Vosselman, G., Xia, G.S., Yilmaz, A., & Yang, M.Y. UAVid: A Semantic Segmentation Dataset for UAV Imagery. ISPRS J. Photogramm. Remote Sens., 2020.

[26] Du, D., Qi, Y., Yu, H., et al. The Unmanned Aerial Vehicle Benchmark: Object Detection and Tracking. ECCV, 2018.

[27] Zhu, P., Wen, L., Bian, X., Ling, H., & Hu, Q. Vision Meets Drones: A Challenge. arXiv:1804.07437, 2018.

[28] Ji, D., Jin, W., Lu, H., & Zhao, F. PPTFormer: Pseudo Multi-Perspective Transformer for UAV Segmentation. arXiv:2406.19632, 2024.

[29] Cao, Y., Huang, X., & Weng, Q. A SAM-adapted Weakly-Supervised Semantic Segmentation Method Constrained by Uncertainty and Transformation Consistency. Int. J. Applied Earth Observation and Geoinformation, 2025.

[30] Kaiming He, Xinlei Chen, Saining Xie, Yanghao Li, Piotr Dollár, and Ross Girshick. Masked autoencoders are scalable vision learners. In CVPR, 2022.

[31] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, DirkWeissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa De-hghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, JakobUszkoreit, and Neil Houlsby. An image is worth 16x16 words:Transformers for image recognition at scale. ICLR, 2021.

[32] Yanghao Li, Hanzi Mao, Ross Girshick, and Kaiming He. Explor-ing plain vision transformer backbones for object detection. ECCV,2022

[33] Matthew Tancik, Pratul Srinivasan, Ben Mildenhall, Sara Fridovich-Keil, Nithin Raghavan, Utkarsh Singhal, Ravi Ra-mamoorthi, Jonathan Barron, and Ren Ng. Fourier features let net-works learn high frequency functions in low dimensional domains.NeurIPS, 2020.

[34]Alec Radford, Jong Wook Kim, Chris Hallacy, Aditya Ramesh, Gabriel Goh, Sandhini Agarwal, Girish Sastry, Amanda Askell, Pamela Mishkin, Jack Clark, et al. Learning transferable visual models from natural language supervision. ICML, 2021

[35] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Lukasz Kaiser, and Illia Polosukhin. Attention is all you need. NeurIPS, 2017.